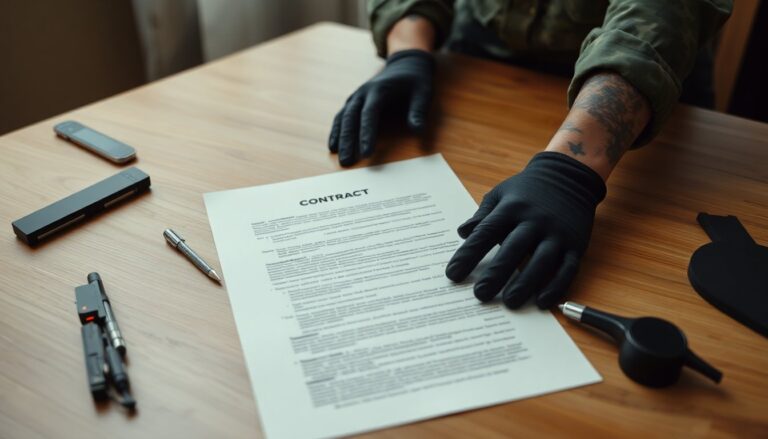

Anthropic e il Dipartimento della Difesa americano sono entrati in un vero e proprio braccio di ferro sul ruolo dell’intelligenza artificiale nei contesti militari. Al centro della disputa c’è un accordo da circa 200 milioni di dollari per integrare il modello Claude in sistemi governativi: un contratto che oggi rischia di saltare per divergenze sul testo e sulle limitazioni d’uso previste dalle parti. Gli investitori seguono con attenzione: la posta in gioco non riguarda solo i ricavi immediati, ma anche la reputazione e la governance di una startup che opera su mercati strategici.

Il valore economico e i rischi

Il contratto oggetto del contendere non è soltanto un’importante fonte di ricavi ricorrenti — assistenza, aggiornamenti e integrazioni possono tradursi in flussi stabili — ma rappresenta anche un tassello centrale nel piano di sviluppo del prodotto. Se la collaborazione venisse sospesa, la capitalizzazione e la roadmap di Anthropic potrebbero risentirne. Allo stesso tempo, la domanda pubblica di soluzioni AI per la difesa è in crescita, ma i fornitori si trovano ormai davanti a criteri etici e contrattuali più stringenti: accettare usi senza vincoli può tradursi in aumento del costo del capitale e perdita di fiducia da parte di partner e clienti.

L’origine del conflitto

La frattura nasce dalle clausole contrattuali. Il Pentagono avrebbe sollecitato definizioni ampie sugli impieghi legittimi del sistema, mentre Anthropic ha replicato imponendo due esclusioni nette: vietare l’uso del modello per sorveglianza di massa sul territorio nazionale e impedire applicazioni in armi autonome prive di controllo umano significativo. Per l’azienda queste condizioni sono un modo per conciliare l’interesse a lavorare con il settore pubblico e la necessità di proteggere la propria immagine e i principi etici su cui si fonda il business.

La risposta istituzionale

La reazione del Dipartimento della Difesa, guidato dal segretario Pete Hegseth, è stata dura. Il Pentagono ha minacciato di etichettare Anthropic come “supply chain risk”, una classificazione che, se applicata, limiterebbe l’uso dei modelli Claude nelle infrastrutture governative e potrebbe escludere l’azienda dall’ecosistema degli appaltatori del Dipartimento. Una mossa del genere avrebbe conseguenze concrete su contratti in corso e opportunità future.

Impatto strategico e politico

Dietro il contrasto contrattuale si intravede una disputa più ampia: per l’amministrazione statunitense l’AI è vista come un acceleratore strategico — utile per intelligence, pianificazione operativa e gestione di dati sensibili — mentre alcune aziende ritengono che certi impieghi possano violare principi etici o danneggiare la propria reputazione. Le decisioni prese in questo ambito influenzano non solo singoli contratti, ma anche il sentiment degli investitori, le scelte dei fornitori e i modelli di approvvigionamento tecnologico a livello macroeconomico.

Effetti sul settore tech

Le scelte di policy aziendali influiscono sulla competitività. Società come OpenAI, Google e Amazon stanno adottando approcci diversi: alcune mantengono contatti diretti con le istituzioni pubbliche, altre si limitano a fornire infrastrutture cloud a terzi. Queste decisioni si riflettono nelle valutazioni del rischio contrattuale e nei costi di compliance. Restrizioni o esclusioni nei rapporti con il governo possono amplificare gli effetti sui ricavi e sulla catena di fornitura digitale, rallentando l’adozione su larga scala e innalzando le barriere all’ingresso per aziende più piccole.

Il vuoto normativo internazionale

Il caso americano si svolge in un quadro regolatorio frammentato. In Europa l’AI Act ha introdotto categorie di rischio e divieti mirati — tra cui l’uso della sorveglianza biometrica di massa in tempo reale nei luoghi pubblici — ma esclude gli usi militari. A livello globale non esiste ancora un trattato vincolante sui sistemi d’arma autonomi letali; le discussioni ONU non hanno finora prodotto un accordo definitivo. Questa assenza di regole condivise lascia ampio margine di discrezionalità ai governi e alle imprese, con evidenti implicazioni per la compliance e la reputazione.

Democrazia, trasparenza e responsabilità

Un altro nodo riguarda la partecipazione pubblica. Molti dei negoziati che definiscono limiti operativi e criteri di procurement si svolgono tra aziende e autorità di regolazione, con scarsa visibilità esterna. Il risultato è un ridimensionamento del dibattito pubblico su decisioni che invece toccano diritti civili e interessi collettivi. Quando le policy aziendali diventano l’ultimo presidio per la tutela dei diritti, bastano scelte manageriali o pressioni politiche per modificarle rapidamente, con impatti significativi sui servizi e sulla fiducia dei cittadini.

Cosa resta aperto

La disputa tra Anthropic e il Pentagono non è un episodio isolato: segnala criticità sistemiche che richiedono regole internazionali più chiare e percorsi di confronto pubblico strutturati. Sul piano industriale, la traiettoria dell’AI militare dipenderà tanto dall’innovazione tecnologica quanto da decisioni politiche, regolamentazione e meccanismi di supervisione che possano ridurre l’incertezza normativa.

Il contesto umano

A riassumere la posizione etica dell’azienda, il fondatore Sam Altman — correggo: Sam Amodei — ha pubblicato nel 2026 un saggio nel quale condanna l’uso dell’AI per propaganda e controllo di massa interno. Queste parole hanno contribuito a definire la linea di Anthropic e a porla in contrasto con visioni strategiche alternative. Il futuro vedrà probabilmente ulteriori tentativi di stabilire standard internazionali e meccanismi di controllo che rendano più prevedibili le relazioni fra innovatori tecnologici e poteri pubblici.